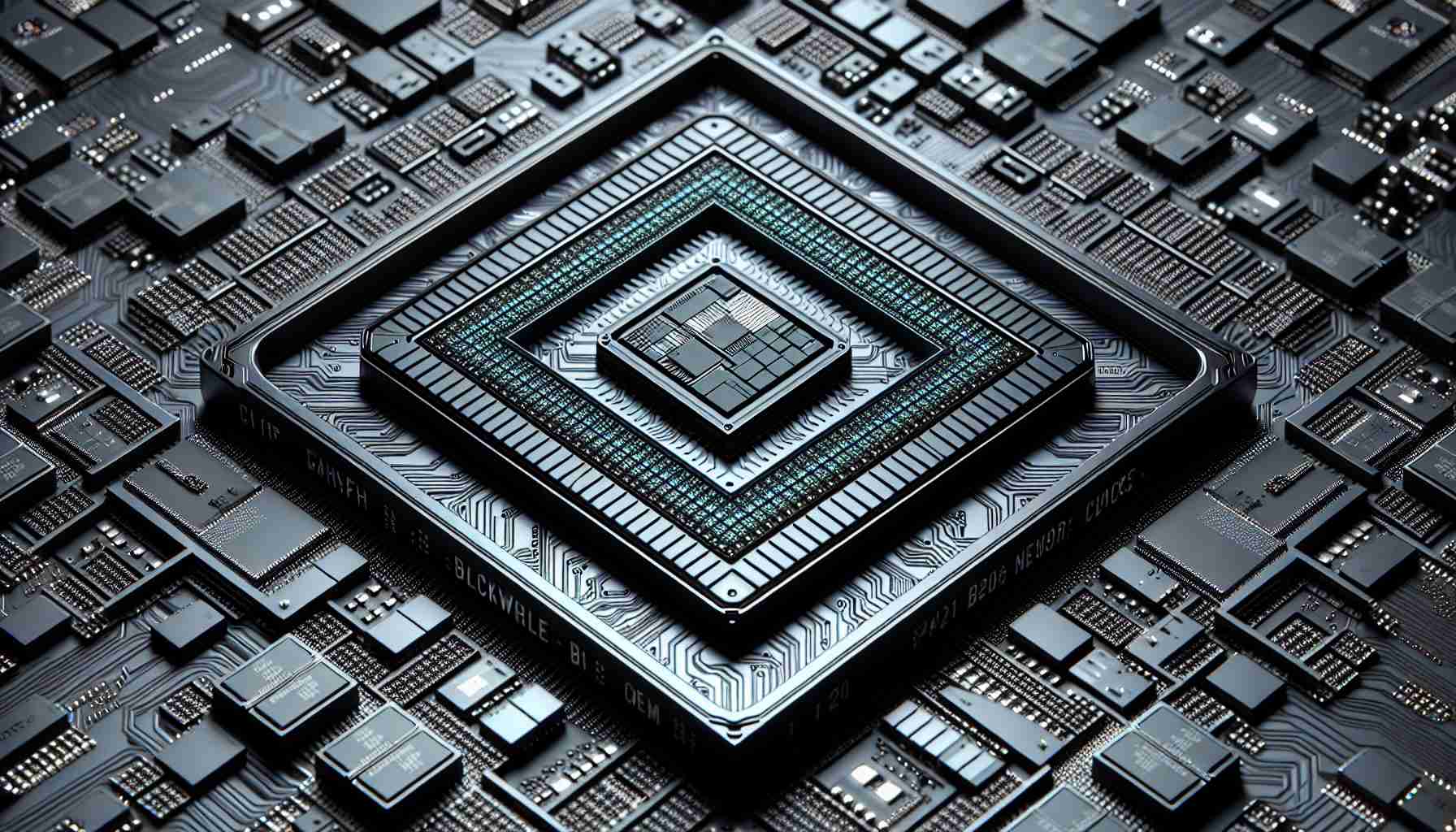

Nvidia niedawno ogłosiła premierę swojego czipu tensorowego Blackwell B200, twierdząc, że jest to najpotężniejsza jednoprocesorowa GPU z imponującymi 208 miliardami tranzystorów. Według Nvidia, czip Blackwell B200 może obniżyć koszty operacyjne i zużycie energii AI inference nawet o 25 razy w porównaniu z jego poprzednikiem, H100. Dodatkowo, Nvidia wprowadziła także GB200, „superchip”, który łączy dwa czipy B200 wraz z procesorem Grace CPU w celu zwiększenia wydajności.

Ogłoszenie zostało zrobione podczas corocznej konferencji GTC Nvidia, na której dyrektor generalny Jensen Huang wygłosił przemówienie. Huang podkreślił potrzebę większych GPU, stwierdzając, że platforma Blackwell umożliwi szkolenie modeli AI o trylionowych parametrach, które przewyższają złożoność obecnych modeli generatywnych AI. GPT-3 z OpenAI, wydany w 2020 roku, miał 175 miliardów parametrów, co stanowi punkt odniesienia dla złożoności modeli AI.

Architektura Blackwell została nazwana na cześć Davida Harolda Blackwella, uznawanego matematyka i pierwszego czarnoskórego ucznia włączonego do National Academy of Sciences. Ta platforma wprowadza sześć technologii do przyspieszonego obliczania, w tym silnik Transformer drugiej generacji, piątą generację NVLink, silnik RAS, możliwości bezpiecznej AI i silnik dekompresji do przyspieszania zapytań bazy danych.

Różne ważne organizacje, takie jak Amazon Web Services, Dell Technologies, Google, Meta, Microsoft, OpenAI, Oracle, Tesla i xAI, wyraziły swoją intencję przyjęcia platformy Blackwell. Komunikat prasowy Nvidii zawiera cytaty od znaczących dyrektorów technicznych, w tym Marka Zuckerberga i Sama Altmana, którzy popierają tę platformę.

Pytania i odpowiedzi (FAQ)

1. Co to jest czip tensorowy Blackwell B200?

Czip tensorowy Blackwell B200 to najpotężniejsze jednoprocesorowe GPU Nvidii, charakteryzujące się imponującymi 208 miliardami tranzystorów. Został zaprojektowany w celu znacznego obniżenia kosztów operacyjnych i zużycia energii AI inference.

2. Jaki jest cel „superchipa” GB200?

„Superchip” GB200 łączy dwa czipy B200 i procesor Grace CPU w celu dalszego zwiększenia wydajności. Jest przeznaczony do zaawansowanych zastosowań i zadań z zakresu sztucznej inteligencji.

3. Jakie organizacje mają zamiar przyjąć platformę Blackwell?

Oczekuje się, że główne firmy, takie jak Amazon Web Services, Dell Technologies, Google, Meta, Microsoft, OpenAI, Oracle, Tesla i xAI, przyjmą platformę Blackwell do swoich operacji opartych na sztucznej inteligencji.

4. W jaki sposób GPU przyczyniają się do zadań AI?

GPU nadają się doskonale do zadań AI ze względu na ich masowo równoległą architekturę, która przyspiesza zadania mnożenia macierzy niezbędne do efektywnego działania sieci neuronowych.

5. Jaka jest istotność czipu Grace Blackwell GB200?

Czip Grace Blackwell GB200 stanowi kluczowy element systemu komputerowego dla centrów danych NVIDIA GB200 NVL72. Umożliwia on udoskonalone szkolenie i inferencję AI oraz oferuje znaczne zwiększenie wydajności w porównaniu z poprzednimi modelami GPU.

6. Czy platforma Blackwell może prowadzić do stworzenia bardziej skomplikowanych modeli AI?

Tak, zwiększona wydajność i możliwości platformy Blackwell mogą umożliwić rozwój bardziej skomplikowanych modeli AI. Jest to szczególnie korzystne dla modeli generatywnych AI, które wymagają znacznej mocy obliczeniowej.

7. Jakie są potencjalne ograniczenia i konkurencja, z którymi boryka się Nvidia na rynku AI?

Mimo znaczących twierdzeń Nvidii dotyczących platformy Blackwell, jej rzeczywista wydajność i przyjęcie przez organizacje pozostaje do zobaczenia. Konkurenci, takie jak Intel i AMD, również aktywnie dążą do postępu w technologii AI, co sprawia, że rynek staje się bardziej konkurencyjny.

Premiera czipu tensorowego Blackwell B200 od Nvidii wzbudziła duże zainteresowanie w branży. Czip ten jest reklamowany jako najpotężniejsze jednoprocesorowe GPU, posiadające imponujące 208 miliardów tranzystorów. Nvidia twierdzi, że Blackwell B200 może obniżyć koszty operacyjne i zużycie energii AI inference nawet o 25 razy w porównaniu z poprzednikiem, H100. Ten postęp ma potencjał rewolucjonizowania obliczeń AI i sprawienia, że będą bardziej dostępne dla szerokiej gamy zastosowań.

Jednym z kluczowych punktów ogłoszenia Nvidia jest wprowadzenie „superchipa” GB200. Ten superchip łączy dw

The source of the article is from the blog hashtagsroom.com