Artyści na całym świecie borykają się z rosnącym problemem, gdy narzędzia sztucznej inteligencji (AI) generują obrazy imitujące ich unikalne style. Mignon Zakuga, ilustratorka okładek książek i artystka wideo gier, była świadkiem sytuacji, w której potencjalni klienci wybierali obrazy generowane przez AI zamiast zlecania pracy ją. To zjawisko budzi zaniepokojenie co do przyszłości młodych i początkujących artystów w branży.

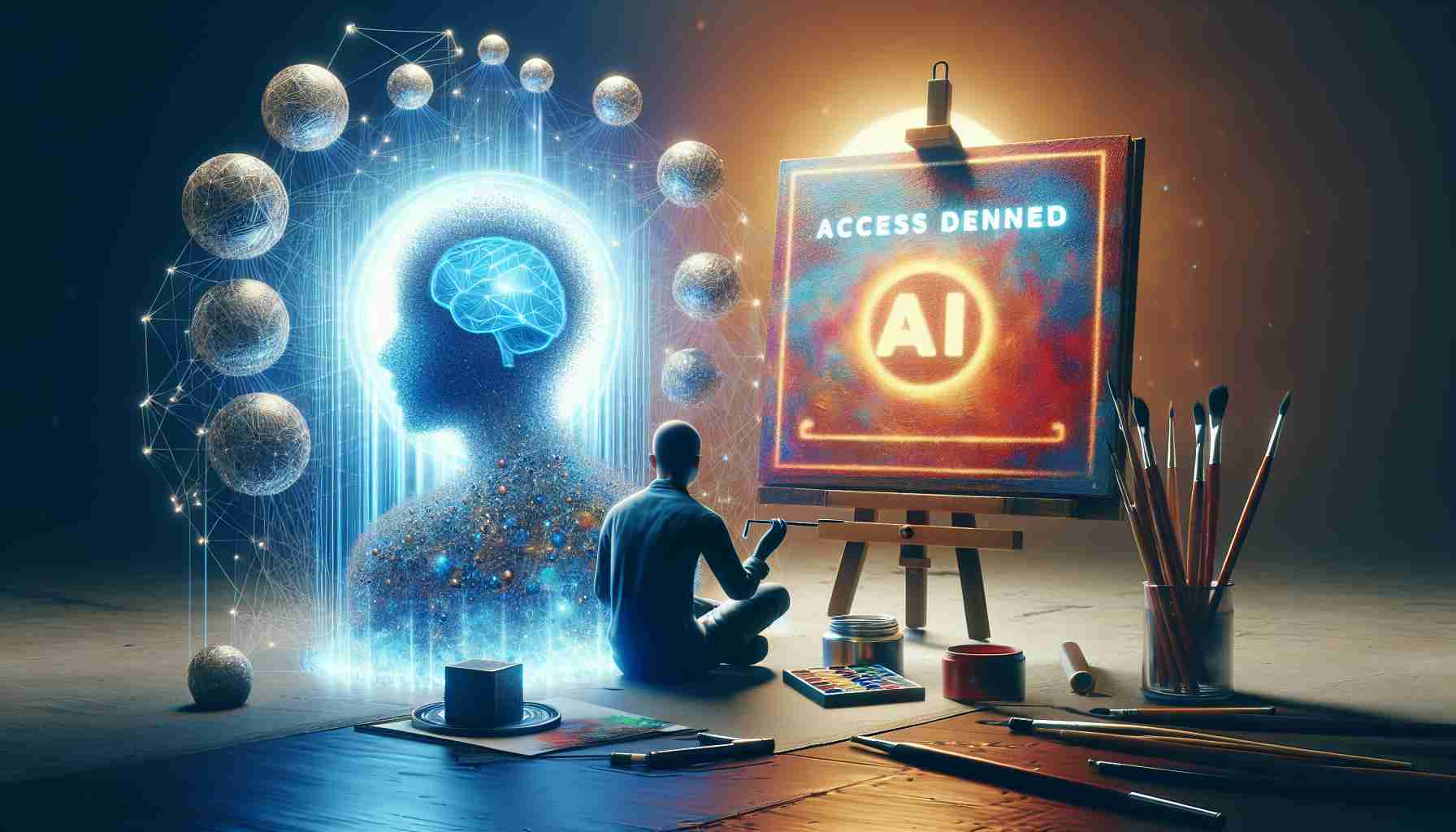

Aby zwalczyć ten problem, badacze z Uniwersytetu w Chicago, Ben Zhao i Heather Zheng, opracowali nowe narzędzia o nazwach Glaze i Nightshade. Te narzędzia mają na celu ochronę pracy artystów poprzez subtelne, niezauważalne dla ludzi zmiany pikseli w obrazie, które wprowadzają zamieszanie dla modeli AI. Podobnie jak iluzje optyczne, te modyfikacje wprowadzają w błąd modele AI, sprawiając, że postrzegają obraz inaczej.

Glaze ma na celu zatuszowanie unikalnego stylu artysty, uniemożliwiając modelom AI uczenie się i replikowanie ich pracy. Poprzez wprowadzanie „Glazed” obrazów do zestawów danych treningowych, modele AI stają się zdezorientowane i produkują mieszane i niedokładne wyniki. Z kolei Nightshade przybiera bardziej agresywne podejście, sabotażując istniejące modele generatywne AI. Narzędzie zamienia potencjalne obrazy treningowe w „truciznę”, ucząc AI niepoprawnego łączenia fundamentalnych pomysłów i obrazów.

Te narzędzia przyniosły pewną ulgę artystom, takim jak Zakuga, którzy regularnie korzystają z Glaze i Nightshade do ochrony swojej pracy. Jednak narzędzia te mają swoje ograniczenia. Zatuszowanie obrazu może być czasochłonne, a chronią nowe prace. Gdy obraz zostanie już uwzględniony w zestawie danych treningowych AI, jest za późno, by go zatuszować. Dodatkowo, nie ma gwarancji, że te narzędzia będą skuteczne w dłuższej perspektywie. W miarę ewolucji modeli AI, metody zatuszowania mogą stać się przestarzałe.

Mimo obecnych ograniczeń, te narzędzia oferują tymczasowe rozwiązanie dla artystów chcących zabezpieczyć swoją pracę przed kopiującymi AI. Badacze, jak Zhao i Zheng, nadal doskonalą i ulepszają te narzędzia, zachowując równowagę między zakłóceniem a zachowaniem integralności obrazu. W miarę trwania gry w kotka i myszkę między artystami a AI, rozwój solidnych i przyszłościowych narzędzi ochrony pozostaje wyzwaniem.

The source of the article is from the blog elperiodicodearanjuez.es