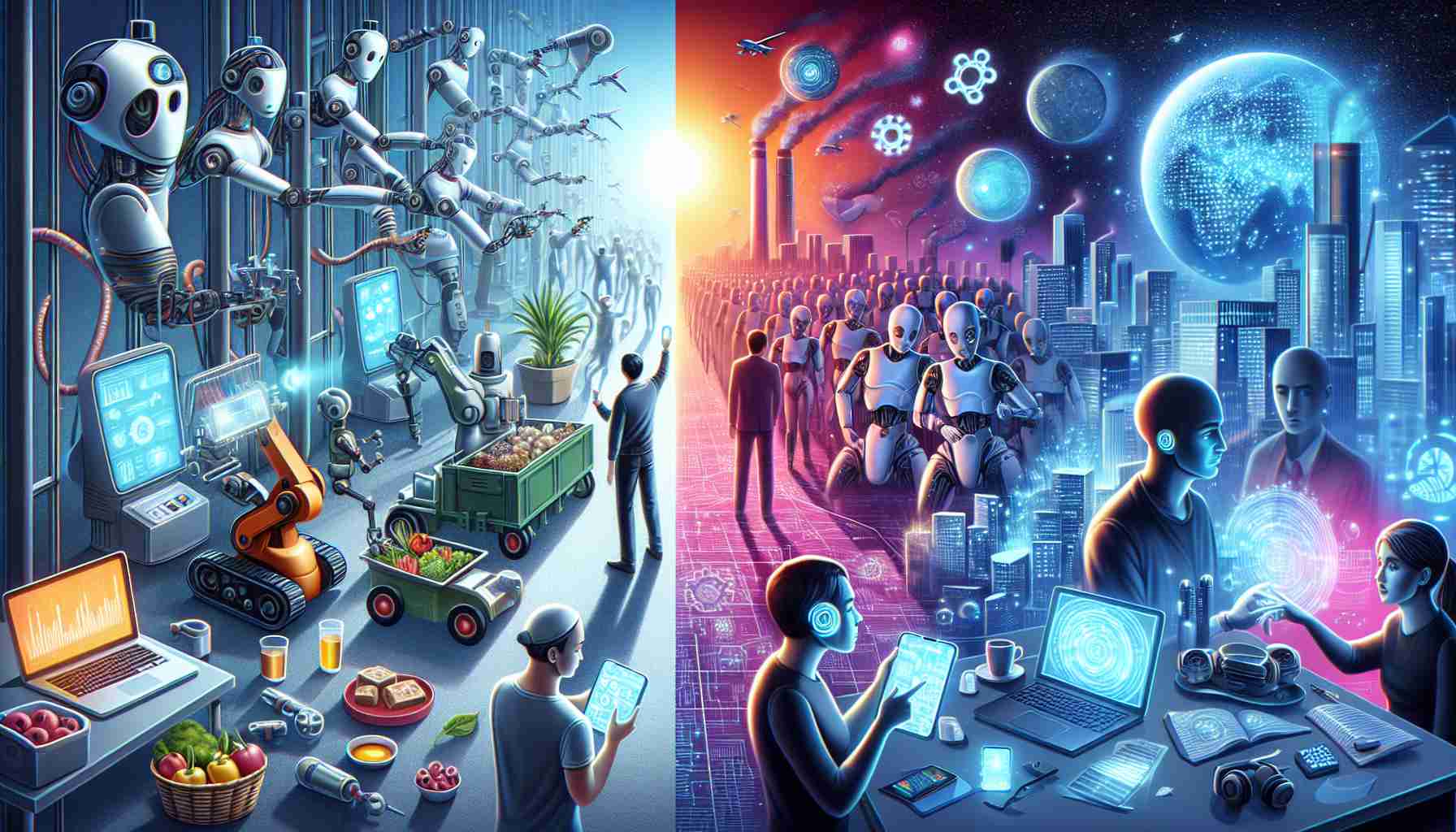

هوش مصنوعی (AI) در سالهای اخیر به طور سریع پیشرفت کرده است، باعث هیجان و نگرانی در مورد تأثیرات بالقوهاش بر انسانیت شده است. جفری هینتون، روانشناس شناختی معروف و دانشمند کامپیوتر، به عنوان یک شخصیت پیشرو در این حوزه شناخته میشود. هینتون که از وظیفهاش در گوگل جدا شده است، نگرانی عمیق خود را درباره قدرت روبهرو شدن هوش مصنوعی و خطرات مرتبط با آن بیان کرده است.

نگرانیهای هینتون حول محقق بودند که هوش مصنوعی قادر است اطلاعات غلط را گسترش دهد، بازار کار را اختلال دهد، و حتی تهدیدات وجودی ارائه دهد. به عنوان یک پیشرو در تکنولوژی شبکههای عصبی که به عنوان پایهای برای هوش مصنوعی عمل میکند، هینتون به مواجهه مسئولین اتحادیه اروپا با تصویب قوانین جدید و نیز اعلام قصد مشابه دولت نیوزلند اشاره کرده است.

در مصاحبه ای با برنامه Nine to Noon از RNZ، هینتون به تفکر خود در ابتدای سال 2023 درباره اینکه کامپیوترهای دیجیتال که شبکههای عصبی را اجرا میکنند ممکن است هوش بیولوژیک را فراتر ببرند اشاره کرد. این تمایل از زمانی آغاز شد که او به تدابیری برای افزایش کارآیی انرژی هوش مصنوعی اندیشید. هینتون آنچنان بر اهمیت قدرت کامپیوترهای دیجیتال تأکید داشت که قدرت آنها در توانایی به اشتراک گذاری دانش با یکدیگر است، که آنها را از لحاظ این مورد به انسانها بسیار برتر میسازد. با چندین نسخه از همان مدل شبکه عصبی، هر کدام جنبههای مختلف اینترنت را یاد میگیرند و میتوانند به طور فوری دانش جمعی خود را به اشتراک بگذارند. این رویکرد شبکهای حافظه کلانی از دانش و تجربه فراتر از هر فردی ایجاد میکند.

هینتون به تشابه بین حافظه انسان و توانایی هوش مصنوعی برای بازخوانی اطلاعات پرتابنده میپردازد. او تأکید دارد که بازخواستن رویدادها از گذشته شامل ترکیب به یادآوری، انجام پیش فرضها و احتمالاً تحریف جزئیات میشود. به طور مشابه، شبکههای عصبی بر ارتباطات بین نورونها برای ایجاد پاسخها یا خروجیهای پذیرفتنی تکیه میکنند. به این ترتیب، شبکههای عصبی بیشتر به مانند پردازشهای انسانی کار میکنند و خطوط مرزی بین درک انسانی و تواناییهای هوش مصنوعی را تاریک میکنند.

موضوع بعدی از نگرانیهای مطرح شده توسط هینتون، افزایش خودخواهی سامانههای هوش مصنوعی است. با ایجاد عوامل مجهز به مدلهای بزرگ، سامانههای هوش مصنوعی قادرند به صورت مستقل عمل کرده و زیر هدفها در قالب برنامههای گسترده را دنبال کنند. اما هینتون باور دارد که احتیاط باید در تعیین این زیر هدفها به کار گرفته شود. اگر بدون کنترل باقی بمانند، سامانههای هوش مصنوعی ممکن است زیر هدفهای ناخواسته ایجاد کنند، که به بروز نتایجی که ممکن است مضر منجر شود منجر میشود. تلاشهایی به منظور توسعه چتباتهای اخلاقی در حال انجام است که اصول اخلاقی را درک کنند و ایمنی و اعتماد آنها را تقویت کنند.

صعود هوش مصنوعی نیز چالشهایی از قبیل مدیریت تهدیدات سایبری به وجود آورده است. هینتون به خطرات مرتبط با افشای مدلهای هوش مصنوعی اشاره میکند. در حالی که افشای مدلها در عموم مفید برای توسعه نرمافزار است، مدلهای هوش مصنوعی بینظیر هستند، زیرا یادگیری آنها توسط دادهها تعیین میشود که ممکن است نتایج پیشبینی ناپذیری داشته باشد. جنایتکاران سایبری میتوانند از این استفاده کنند و مدلها را برای فعالیتهای غیرقانونی مانند جرائم سایبری یا حملات فیشینگ بهینه کنند. هینتون علیه افشای مدلهای بزرگ هوش مصنوعی است دلیل آن این استکه افشای مدلها به جرمی برای آموزش مدلهای خود جرمی برای جنایتکاران را از بین میبرد و باعث میشود تهدیدات سایبری رایجتر شود.

زمانی که هوش مصنوعی به پیشرفت ادامه میدهد، افزایش نگرانیها در مورد جایگزینی شغلها وجود دارد. هینتون اظهار میدارد که کارهای فکری روتین ممکن است موقعیتی مشابه با کارهای دستی روتین را برای الگوریتمهای هوش مصنوعی ایجاد کنند که توانایی انسانها را فراتر میبرند. در حالی که اقتصاددانان در پیشبینیهای خود تفاوت دارند، بروز یک سلسله مراتب هوشمندتر سوالاتی برای آینده مطرح میکند. صندوق بینالمللی پول (IMF) اخطار میدهد که هوش مصنوعی میتواند منجر به کاهش 40٪ی در مشاغل شود و نابرابریها را تشدید کند.

پیشرفت هوش مصنوعی نیز نگرانیهایی را در مورد نقش آن در تأثیر گذاری بر فرایندهای دموکراتیک به ارمغان آورده است. هینتون به تواناییهای تولید تصاویر، ویدئوها و صدا در هوش مصنوعی اشاره میکند که ممکن است در دورههای انتخاباتی بهرهجویی شوند، که این امر ممکن است فرایند دموکراتیک را تحت تأثیر قرار دهد یا آن را فاسد کند.

هر چند هیتون به رویکردهای تنظیمی و استفاده احتیاطی هوش مصنوعی تشویق میکند، اما او موافق ماندگاری گفتگوهایی که پیرامون آیندهاش صورت گرفته است است. توازن در بهرهبرداری از ظرفیتهای هوش مصنوعی و به حداقل رساندن خطرات آن، تضمین میکند که پیشرفتهای فناوری برای بهبود بشریت خدمت کند.

پرسشهای متداول (FAQ)

The source of the article is from the blog cheap-sound.com