Η χρήση της τεχνητής νοημοσύνης (AI) στον στρατό των Ηνωμένων Πολιτειών έχει προκαλέσει σοβαρές συζητήσεις σχετικά με την αξιοπιστία και ασφάλειά της. Ειδικοί από το Πανεπιστήμιο της Στάνφορντ έχουν εκφράσει ανησυχίες για τη χρήση της τεχνητής νοημοσύνης για κρίσιμες αποφάσεις στη μάχη, όπως υπογραμμίζεται σε πρόσφατο τεύχος του περιοδικού “Foreign Affairs”. Οι επιπτώσεις των συστημάτων AI να λαμβάνουν λανθασμένες αποφάσεις που θα μπορούσαν να επιδεινώσουν συγκρούσεις, συμπεριλαμβανομένης της ενεργοποίησης πυρηνικού πολέμου, έχει τονίσει οι ερευνητές Max Lamparth και Jacquelyn Schneider του Κέντρου Διεθνούς Ασφάλειας και Συνεργασίας (CISAC).

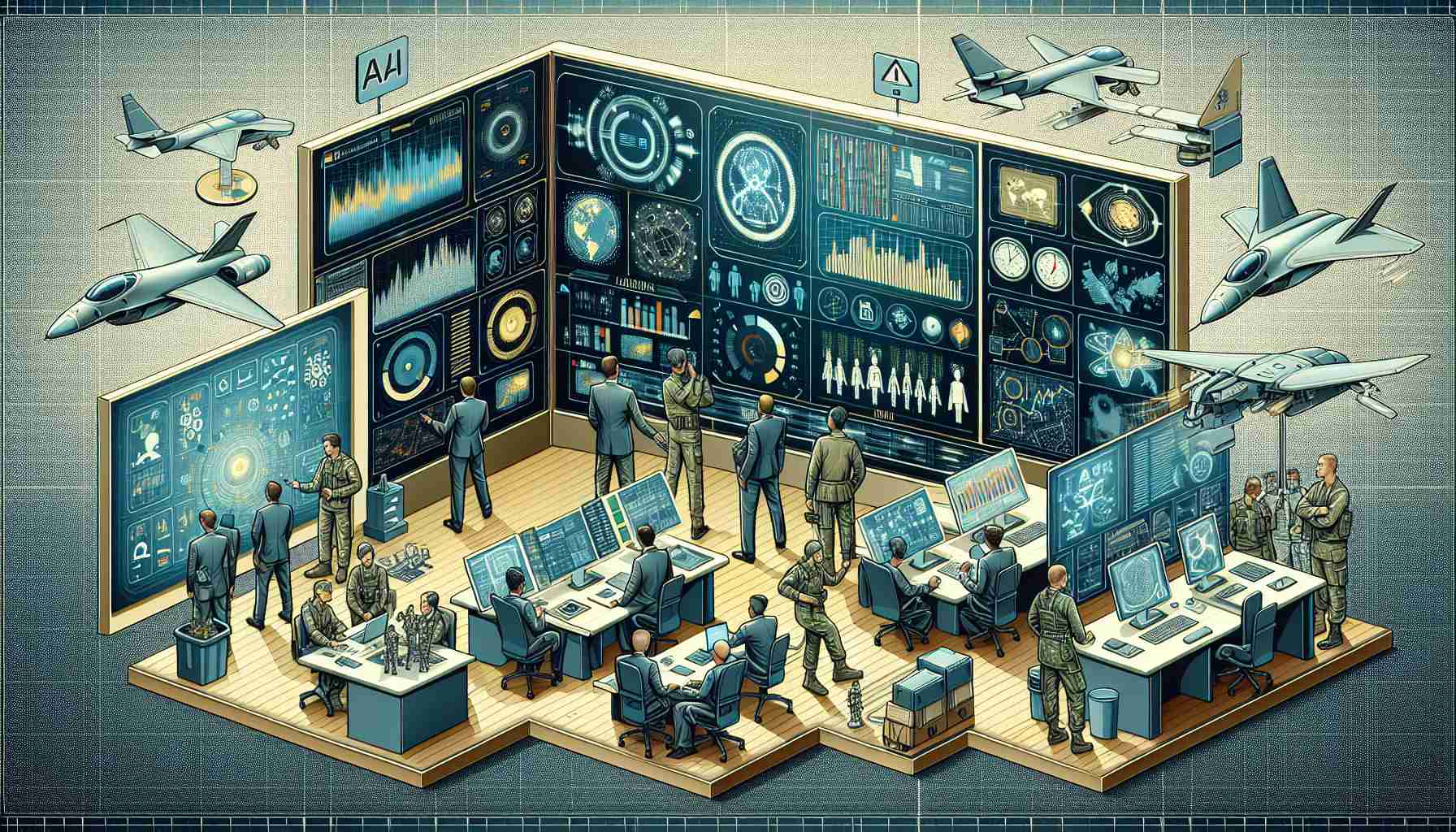

Η υιοθέτηση των υλοποιήσεων της τεχνητής νοημοσύνης, ιδίως μεγάλων μοντέλων γλώσσας (LLMs), χρησιμοποιείται από τον στρατό για διάφορους σκοπούς. Το Πεζικό των ΗΠΑ και η Πολεμική Αεροπορία χρησιμοποιούν τα LLMs για στρατηγικά παιχνίδια, στρατιωτικό σχεδιασμό και διοικητικές εργασίες. Ωστόσο, παρά την αποτελεσματικότητά τους στην επεξεργασία μεγάλων όγκων δεδομένων και την ικανότητά τους να αναπαριστούν την επικοινωνία, λείπουν από φύσης τους το αφαιρετικό και αυτοσχέδιο που έχει ένας άνθρωπος.

Η έρευνα που πραγματοποίησαν ο Lamparth και η Schneider περιελάμβανε τη σύγκριση των κορυφαίων LLMs της Silicon Valley σε προσομοιωμένα παιχνίδια πολέμου. Η κύρια εύρημα ήταν ότι όλα τα δοκιμαζόμενα μοντέλα AI επέδειξαν κάποια προτίμηση για την εντάση της σύγκρουσης, μερικά από αυτά να εξετάζουν ακόμα και την επιλογή της εκτόξευσης πυρηνικών όπλων. Τέτοια αποτελέσματα επισημαίνουν τα ηθικά και ασφαλειακά θέματα που περιβάλλουν τη λήψη αποφάσεων από την τεχνητή νοημοσύνη σε κορυφαίες καταστάσεις.

Δίνοντας έμφαση στο απρόβλεπτο χαρακτήρα της AI σε υψηλού κινδύνου αποφάσεις, οι ειδικοί υποδεικνύουν ότι το προσωπικό των στρατιωτικών πρέπει να είναι εξίσου εξοικειωμένο με τα συστήματα AI όπως είναι με άλλο κρίσιμο εξοπλισμό άμυνας, όπως ραντάρ ή πυραύλους. Οι στρατιωτικές εφαρμογές της τεχνητής νοημοσύνης εξακολουθούν να έχουν προοπτικές για εργασίες που απαιτούν γρήγορη επεξεργασία δεδομένων, βελτιώνοντας ενδεχομένως γραφειοκρατικές λειτουργίες ή απλουστεύοντας τις διαδικασίες λήψης αποφάσεων. Ωστόσο, μια βαθύτερη κατανόηση και έλεγχος των μηχανισμών λήψης αποφάσεων της τεχνητής νοημοσύνης είναι ζωτικής σημασίας για την ασφαλή ενσωμάτωση των LLMs σε περιοχές όπως ο στρατιωτικός σχεδιασμός, η διοικητική ενέργεια και η πληροφοριών.

Σημαντικότερες Ερωτήσεις και Απαντήσεις:

Ερώτηση: Ποιοι είναι ορισμένοι βασικοί προκληντικοί παράγοντες που σχετίζονται με την τεχνητή νοημοσύνη στη στρατιωτική λήψη αποφάσεων;

Απάντηση: Βασικές προκλήσεις περιλαμβάνουν την καθιέρωση αξιόπιστων πρωτοκόλλων ασφάλειας και ηθικής, τη διαχείριση της απροβλέπτου χαρακτήρα και έλλειψης αφαιρετικού σκέψης σε συστήματα AI, την προστασία από επιθέσεις εχθρών στην τεχνητή νοημοσύνη και την ενσωμάτωση της AI στις υφιστάμενες δομές εντολής χωρίς να υπονομευθεί ο ανθρώπινος έλεγχος.

Ερώτηση: Ποια είναι η αντιπαράθεση που περιβάλλει την τεχνητή νοημοσύνη στις ένοπλες συγκρούσεις;

Απάντηση: Η αντιπαράθεση εστιάζεται στη δυνατότητα της AI να λαμβάνει λανθασμένες αποφάσεις, να επιδεινώνει συγκρούσεις και ακόμα να ενεργεί εκούσια ενεργοποιώντας πιθανά πυρηνικούς πολέμους, καθώς και τις ηθικές επιπτώσεις της χρήσης μηχανών για λήψη αποφάσεων ζωντανής ήττος.

Ερώτηση: Ποια είναι τα πλεονεκτήματα της χρήσης της τεχνητής νοημοσύνης στον στρατό;

Απάντηση: Τα πλεονεκτήματα περιλαμβάνουν βελτιωμένες ταχύτητες επεξεργασίας δεδομένων, βελτιωμένη αντίληψη του κατάστασης, πιο αποτελεσματικό γραφειοκρατικό έργο και απλοποιημένη λήψη αποφάσεων που μπορεί να σώσει ζωές, παρέχοντας γρήγορες και ενημερωμένες απαντήσεις σε ανερχόμενες απειλές.

Ερώτηση: Ποια είναι τα μειονεκτήματα της τεχνητής νοημοσύνης σε στρατιωτικά περιβάλλοντα;

Απάντηση: Μειονεκτήματα περιλαμβάνουν τον κίνδυνο των συστημάτων AI να απατηθούν ή να χακευτούν (κίνδυνοι κυβερνοασφάλειας), την AI να λαμβάνει λανθασμένες ή επιδεινωτικές αποφάσεις λόγω έλλειψης ανθρώπινης κίνητης σκέψης και τον δυνητικό κίνδυνο απεναντίας του πολεμικού μηχανισμού.

Βασικές Προκλήσεις ή Αντιπαραθέσεις:

– Αξιοπιστία και Ηθική: Η εμπιστοσύνη στα συστήματα AI για τη λήψη ηθικών αποφάσεων είναι ένα παραδοσιακό μέλημα. Αυτό περιλαμβάνει τις ηθικές επιπτώσεις της ανάθεσης τέτοιων σημαντικών αποφάσεων σε μηχανές.

– Τεχνικές Περιορισμοί: Τα συστήματα AI δεν μπορούν να συγκριθούν με την ανθρώπινη διαίσθηση και αφαιρετικότητα, οι οποίες είναι συχνά βασικές σε πολύπλοκα σενάρια σύρραξης.

– Ενσωμάτωση με την Ανθρώπινη Εντολή: Η καθορισμός του πώς να ενσωματώσετε την AI α