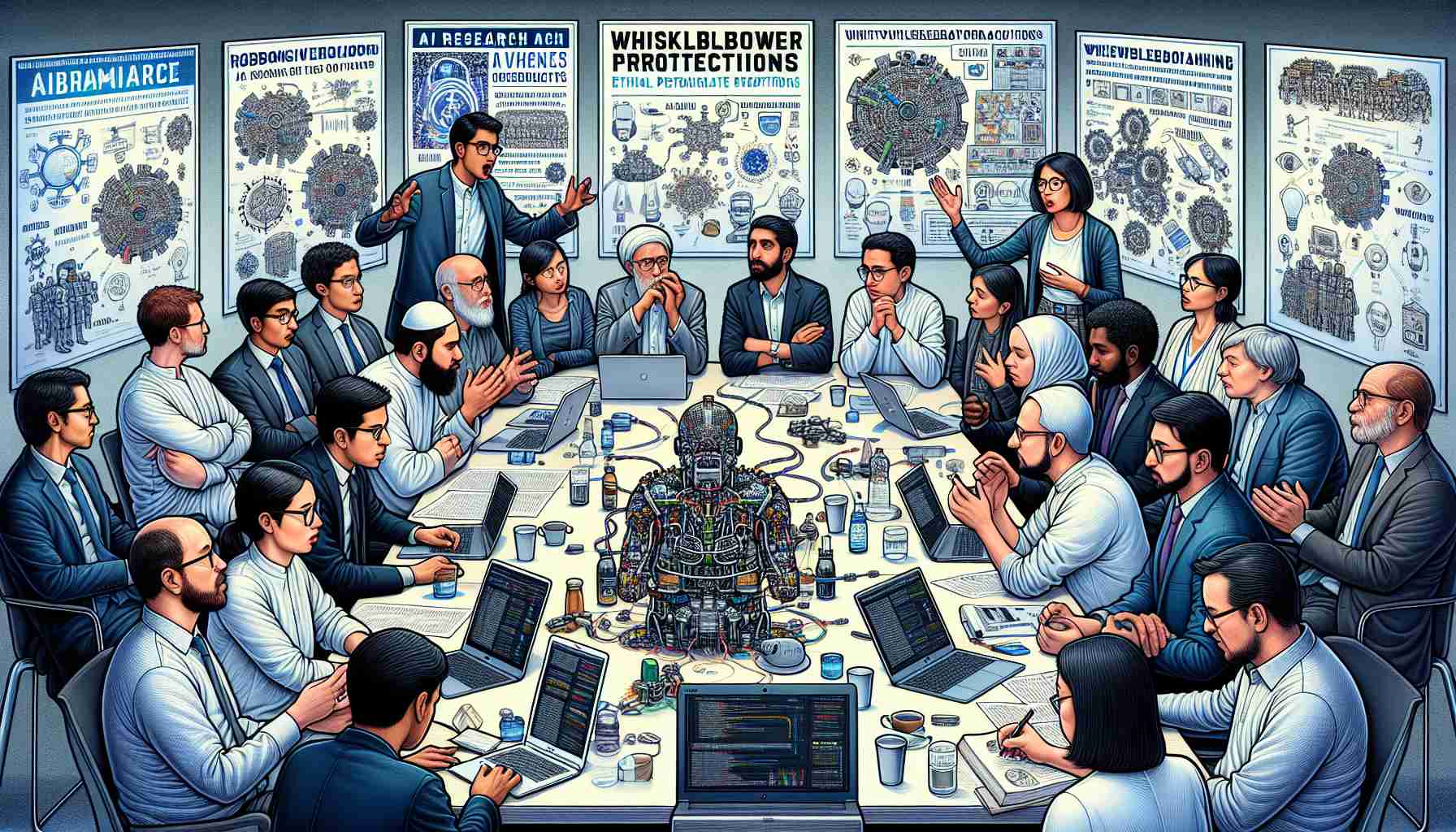

الخبراء في مجال الذكاء الاصطناعي يطالبون بحقهم في الكشف العلني عن التهديدات المحتملة التي تشكلها تقنيات الذكاء الاصطناعي، مصرين على أن حماية المبلغين الحالية غير كافية. جرى هذا النداء يوم الثلاثاء في خطاب مفتوح يعبر عن قلقه من أن هذه الضمانات عادة ما تكون مصممة ضد السلوك الشركاتي غير القانوني، في حين أن الأطر القانونية للذكاء الاصطناعي غالبًا ما تكون غير موجودة. يُحجج الخبراء بأن هذا يترك الباحثين عرضة للانتقام، مشيرين إلى حوادث سابقة داخل الصناعة.

وفي هذا السياق، يتم اقتراح أربع مبادئ أساسية للشركات التي تمتلك أنظمة ذكاء اصطناعي متقدمة. أولاً، يجب ألا يتم رقابة الموظفين عن التحدث ضد أرباب عملهم. تم توضيح هذه النقطة من خلال الأحداث الأخيرة في شركة OpenAI، حيث تم تهديد الموظفين السابقين بفقدان خيارات الأسهم في حال قاموا بتشويه سمعة الشركة. اعتذر الرئيس التنفيذي سام ألتمان فيما بعد وقام بإزالة البند الجدلي، مدعيًا أنه لم يتم تطبيقه أبدًا.

كما تدعو الرسالة المفتوحة إلى وجود عملية تسمح للموظفين بإبلاغ مجالس الإدارة والجهات التنظيمية بشكل مجهول حول المخاطر المتصورة المرتبطة ببرامج الذكاء الاصطناعي، ممنحين لهم حرية الكشف العلني في حال عدم وجود طرق داخلية للتبليغ. يُعتبر هذا الإجراء أساسيًا نظرًا لسرعة تقدم الذكاء الاصطناعي، محذرين من النتائج المحتملة التي تتراوح بين فقدان وظائف جماعي كبير إلى انتشار المعلومات الخاطئة وحتى تهديدات لوجود الإنسان.

تتحرك الحكومات لاتخاذ تدابير، حيث تقوم بوضع تشريعات لتطوير الذكاء الاصطناعي، وتعتبر OpenAI في طليعة الابتكار في الصناعة. على الرغم من المخاوف المعبرة عنها، أكد المتحدث باسم OpenAI التزامه بالنهج العلمي في التعامل مع المخاطر التكنولوجية.

من بين الذين وقعوا على الرسالة، اختار أربعة من موظفي OpenAI الحاليين واثنان من السابقين البقاء مجهولين الهوية، بينما أيد سبعة بوضوح، بما في ذلك أفراد كانوا سابقًا مرتبطين بـ OpenAI وDeepMind التابعة لشركة Google. أوضح نيل ناندا من DeepMind، الذي كان سابقًا في شركة أنثروبيك للذكاء الاصطناعي، أن تحذيره ليس مقتنيًا على أساس أي حوادث محددة في مكان عمله الحالي أو السابق.

أسئلة وإجابات مهمة:

1. ماذا تعني حماية المبلغين؟

تحمي حماية المبلغين الأفراد الذين يبلغون عن أنشطة غير أخلاقية أو غير قانونية داخل منظمتهم. هذه الحمايات أساسية للسماح للموظفين بالتحدث دون خوف من الانتقام.

2. لماذا يطالب الباحثون في مجال الذكاء الاصطناعي بحماية المبلغين؟

يطالب الباحثون في مجال الذكاء الاصطناعي بحماية المبلغين نظرًا لأن القوانين الحالية قد لا تغطي بشكل كافٍ التحديات الفريدة التي تطرحها تقنيات الذكاء الاصطناعي، والتي يمكن أن تشمل مسائل قانونية وأخلاقية لا يتم عادة معالجتها بالتشريعات القائمة.

3. ما هي المبادئ المقترحة للشركات؟

تتضمن المبادئ السماح للموظفين بالتحدث ضد أرباب عملهم دون رقابة، وتنفيذ عملية للإبلاغ بشكل مجهول لمجالس الإدارة والجهات التنظيمية حول المخاطر المرتبطة ببرامج الذكاء الاصطناعي.

التحديات والجدل:

الاعتبارات الأخلاقية: مع تقدم تكنولوجيا الذكاء الاصطناعي، تزداد الصراعات الأخلاقية، مثل القدرة على اتخاذ قرارات متحيزة، وانتهاكات الخصوصية، والحكم الذاتي في تطبيقات الذكاء الاصطناعي العسكرية.

الأطر القانونية: توجد نقص في الأطر القانونية الشاملة التي تحكم الذكاء الاصطناعي، مما يمكن أن يؤدي إلى فجوة في المساءلة وحماية المبلغين.

تهديد الانتقام: قد يواجه المبلغون أشكالًا مختلفة من الانتقام، بما في ذلك الفصل من العمل، أو التخفيض في الرتبة، أو التحرش، الأمر الذي يثني الموظفين عن تقديم المعلومات الحرجة.

المزايا والعيوب:

المزايا:

– تعزيز تطوير الذكاء الاصطناعي المسؤول الذي يأخذ في الاعتبار رفاهية المجتمع.

– تشجيع الشفافية والمساءلة داخل صناعة الذكاء الاصطناعي.

– خفض احتمال وجود ممارسات ضارة في مجال الذكاء الاصطناعي التي يمكن أن تؤدي إلى عواقب كبيرة.

العيوب:

– يمكن للشركات أن تجادل بأن مثل هذه الحمايات يمكن أن تؤدي إلى كشف غير مبرر قد يضر بموقفها التنافسي أو يؤدي إلى حدوث ذعر غير مبرر.

– يمكن أن ينظر إلى حماية المبلغين على أنها عوائق للابتكار بوتيرة سريعة، مما قد يقيد التطور في مجال الذكاء الاصطناعي.

روابط ذات صلة مقترحة:

– لاستكشاف آخر التطورات في مجال الذكاء الاصطناعي والمناقشات حول الذكاء الاصطناعي الأخلاقي، قم بزيارة موقع OpenAI الرسمي: OpenAI

– للحصول على رؤى معمقة في البحث الحديث في مجال الذكاء الاصطناعي، قم بزيارة موقع DeepMind: DeepMind

تم التحقق من تضمين كل رابط للتأكد من توجيهه إلى النطاق الرئيسي للمنظمات المذكورة في المقال.

The source of the article is from the blog combopop.com.br