W szybko rozwijającej się dziedzinie sztucznej inteligencji (AI) zapotrzebowanie na skuteczną i wydajną moc obliczeniową doprowadziło do znacznych postępów w technologiach sprzętowych. Wśród tych innowacji, jednostki przetwarzania tensorowego (TPU) stały się kluczowymi komponentami zaprojektowanymi specjalnie do zadań związanych z uczeniem maszynowym. Celem tego artykułu jest dostarczenie dogłębnego zrozumienia TPU, ich architektury, zastosowań i korzyści.

Co to są jednostki przetwarzania tensorowego?

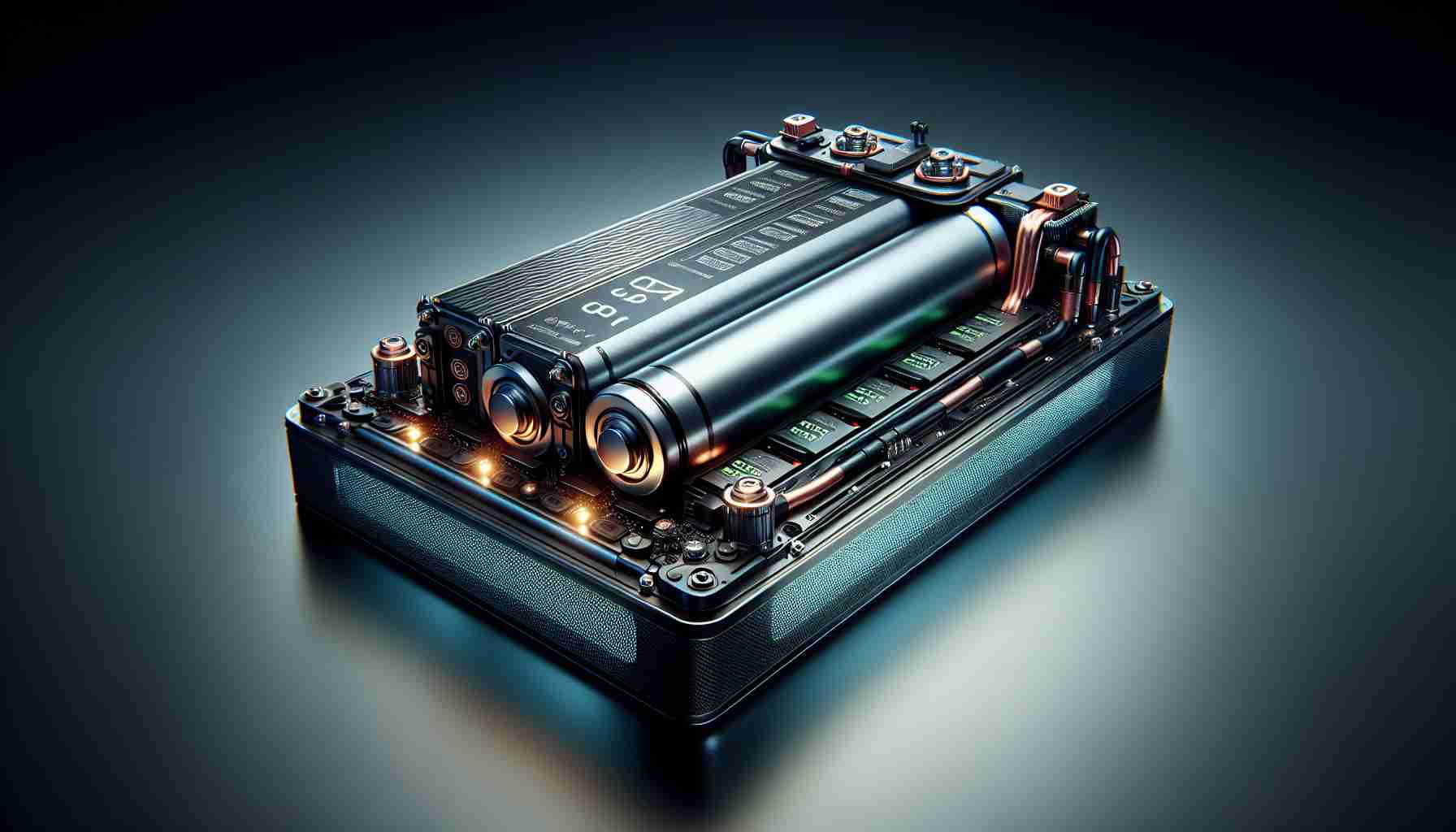

Jednostki przetwarzania tensorowego to specjalizowane przyspieszacze sprzętowe opracowane przez Google w celu poprawy wydajności obciążeń związanych z uczeniem maszynowym i głębokim uczeniem. Wprowadzone w 2016 roku, TPU są zoptymalizowane do dużych mnożeń macierzy i operacji tensorowych, które są powszechnie spotykane w sieciach neuronowych. Ich architektura pozwala na masowe przetwarzanie równoległe i efektywne przetwarzanie, co czyni je niezwykle odpowiednimi do trenowania i wnioskowania modeli AI.

Kluczowe cechy TPU

Jedną z wyróżniających cech TPU jest ich wysoka przepustowość w operacjach tensorowych. W przeciwieństwie do tradycyjnych CPU i GPU, które są zaprojektowane do szerokiego zakresu zadań, TPU są dostosowane specjalnie do potrzeb uczenia maszynowego. Ta specjalizacja prowadzi do znacznych popraw wydajności. Na przykład, TPU mogą wykonywać ogromne ilości mnożeń i dodawania w ułamku czasu potrzebnego dla konwencjonalnego procesora.

Kolejnym ważnym aspektem jest efektywność energetyczna. TPU oferują przewagę wydajności na wat, co czyni je idealnymi do dużych wdrożeń w centrach danych. Ta efektywność nie tylko obniża koszty operacyjne, ale także przyczynia się do działań na rzecz zrównoważonego rozwoju, minimalizując zużycie energii.

Architektura TPU

Architektura TPU zazwyczaj składa się z jednostki mnożenia macierzy, jednostki przetwarzania wektorowego oraz systemu pamięci o wysokiej przepustowości. Jednostka mnożenia macierzy, znana jako rdzeń TPU, jest sercem urządzenia, umożliwiając skalowalne przetwarzanie operacji głębokiego uczenia. Połączenia w obrębie TPU umożliwiają szybki przepływ informacji między rdzeniami, co przyspiesza przetwarzanie złożonych modeli.

TPU są dostępne w różnych wersjach, mianowicie TPU v2, v3 i nowszych iteracjach. Każda wersja zwiększa moc obliczeniową i pojemność pamięci, co pozwala na efektywne trenowanie jeszcze większych i bardziej złożonych modeli.

Zastosowania TPU

TPU są szeroko stosowane w różnych sektorach, w szczególności w aplikacjach związanych z dużymi zestawami danych i głębokim uczeniem. Są wykorzystywane w przetwarzaniu języka naturalnego (NLP), widzeniu komputerowym oraz systemach rekomendacji. Co ciekawe, Google wykorzystuje TPU w swoich produktach, takich jak Google Photos i Google Translate, znacznie zwiększając ich wydajność i doświadczenia użytkowników.

Ponadto TPU rozszerzyły swoje zastosowanie w środowiskach badawczych, pozwalając naukowcom i badaczom na rozwiązywanie skomplikowanych problemów, takich jak składanie białek i modelowanie klimatu, z niespotykaną prędkością i dokładnością.

Uzyskiwanie dostępu i korzystanie z TPU

Dla programistów i badaczy, którzy chcą korzystać z TPU, Google Cloud oferuje dostępne opcje za pośrednictwem swojej platformy AI. Użytkownicy mogą łatwo integrować TPU w swoich przepływach pracy związanych z uczeniem maszynowym, dynamicznie skalując obliczenia w zależności od potrzeb projektu. Ponadto wiele popularnych frameworków do uczenia maszynowego, w tym TensorFlow, ma wbudowane wsparcie dla TPU, co ułatwia ich wdrażanie.

Podsumowanie

Podsumowując, jednostki przetwarzania tensorowego rewolucjonizują krajobraz obliczeń sztucznej inteligencji. Dzięki dedykowanej architekturze do zadań związanych z uczeniem maszynowym, wyjątkowej wydajności i efektywności energetycznej, TPU kształtują przyszłość rozwoju i wdrażania AI. W miarę jak świat coraz bardziej zwraca się ku rozwiązaniom opartym na AI, zrozumienie i wykorzystanie możliwości TPU będzie niezbędne dla organizacji dążących do sukcesu w tej konkurencyjnej dziedzinie. Kontynuowany rozwój TPU obiecuje dalsze wsparcie dla innowatorów i badaczy, torując drogę do przełomów, które kiedyś wydawały się być na horyzoncie.

Popraw swoje doświadczenie z AI: wskazówki, triki życiowe i interesujące fakty o jednostkach przetwarzania tensorowego

W miarę jak krajobraz technologiczny ewoluuje, zrozumienie narzędzi, które masz do dyspozycji, staje się kluczowe, szczególnie w dziedzinach takich jak sztuczna inteligencja (AI). Biorąc pod uwagę rosnące znaczenie jednostek przetwarzania tensorowego (TPU), oto kilka wskazówek, trików życiowych i intrygujących faktów, które pomogą Ci maksymalnie wykorzystać swoje doświadczenie z tymi potężnymi przyspieszaczami sprzętowymi.

Wskazówki dotyczące skutecznego korzystania z TPU

1. Zacznij od małych modeli: Jeśli dopiero zaczynasz przygodę z TPU, zacznij od mniejszych modeli, aby zrozumieć, jak działają. Takie podejście pozwala zapoznać się z infrastrukturą i narzędziami bez przytłaczania systemu lub ponoszenia wysokich kosztów.

2. Optymalizuj swój kod: Zawsze optymalizuj swój kod uczenia maszynowego pod kątem TPU. Używaj wydajnych potoków danych i upewnij się, że architektura Twojego modelu w pełni wykorzystuje możliwości mnożenia macierzy TPU. Biblioteki takie jak TensorFlow są wyposażone w narzędzia specjalnie zaprojektowane do optymalizacji TPU.

3. Wykorzystuj uczenie transferowe: Wykorzystuj gotowe modele, gdzie tylko to możliwe. Uczenie transferowe może znacznie zredukować zasoby wymagane do trenowania modelu od podstaw, co czyni korzystanie z TPU bardziej efektywnym i oszczędza cenny czas.

Triki życiowe dla badaczy i programistów

– Monitoruj wykorzystanie zasobów: Obserwuj wykorzystanie zasobów TPU za pośrednictwem pulpitu Google Cloud. Pomaga to podejmować świadome decyzje dotyczące skalowania w górę lub w dół w zależności od potrzeb i ograniczeń projektu.

– Eksperymentuj z wersjami TPU: Nie wahaj się badać różnych wersji TPU. Każda wersja oferuje różne usprawnienia, które mogą przynieść korzyści w różnych zadaniach. Wybór odpowiedniej wersji w zależności od specyficznego obciążenia roboczego może prowadzić do lepszej wydajności i oszczędności kosztów.

– Wsparcie społeczności: Angażuj się w internetowe fora i społeczności skupiające się na TPU i TensorFlow. Strony takie jak fora TensorFlow oferują mnóstwo informacji bezpośrednio od innych użytkowników i programistów, którzy dzielą się swoimi doświadczeniami i rozwiązaniami.

Interesujące fakty o TPU

– Zaprojektowane dla Google: TPU zostały pierwotnie opracowane dla wewnętrznych potrzeb Google, ale od tego czasu stały się dostępne dla użytkowników chmurowych. Daje to programistom dostęp do tego samego zaawansowanego sprzętu, który zasila popularne usługi Google.

– Wielokrotne wdrożenia: Firmy takie jak Nvidia i AMD skoncentrowały się na przyspieszaczach GPU, jednak TPU doskonale sprawdzają się w specyficznych zadaniach AI, takich jak trenowanie i wnioskowanie sieci neuronowych, co czyni je unikalnym narzędziem w zestawie narzędzi AI.

– Wpływ na zrównoważony rozwój: Efektywność energetyczna TPU nie tylko pomaga w obniżeniu kosztów, ale także wpisuje się w globalne cele zrównoważonego rozwoju. Korzystanie z TPU może zmniejszyć ślad węglowy w dużych centrach danych.

Podsumowanie

Badanie i korzystanie z jednostek przetwarzania tensorowego może znacznie poprawić Twoje projekty w dziedzinie sztucznej inteligencji. Wdrożenie tych wskazówek i sztuczek, a także zrozumienie technologii, pozwoli Ci w pełni wykorzystać potencjał TPU. W miarę postępujących innowacji w AI, pozostawanie na bieżąco z narzędziami takimi jak TPU, pozwoli Ci wyprzedzić konkurencję. Po więcej informacji i szczegółów na temat jednostek przetwarzania tensorowego odwiedź Google Cloud w celu uzyskania dodatkowych zasobów i informacji.