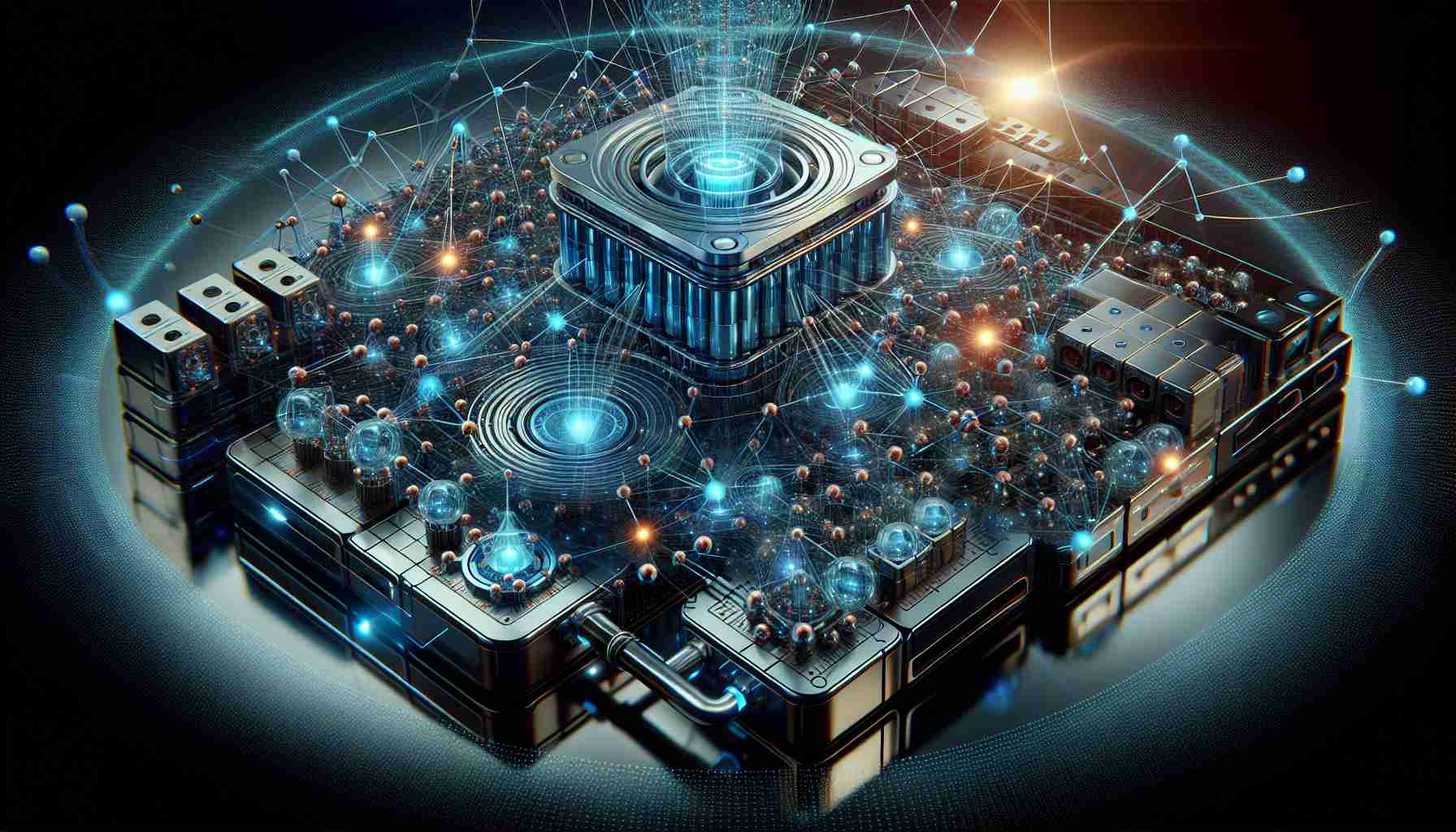

I dagens raskt skiftande teknologiske landsskap vender bedrifter seg i aukande grad mot innovative AI-løysingar som ChatGPT for ulike tenester. Desse AI-verktøya byr på bekvemmeligheit, men dei fører òg med seg betydelege tryggingsrisikoar.

Innsatsar for å førebygge teknologislepp gjennom AI-system er i gang blant føretak i ulike regionar. Bedrifter, som den miljøvennlige verksemda Panashia, nyttar ChatGPT for å utvikle fjernkundetenester med forbetra tryggingstiltak. Panashia har lagt merke til sårbarheita til desse teknologiane og har implementert streng tryggingsprotokollar i samarbeid med nasjonale etterretningstenester og lovvhandheving for å hindre datalekkasje.

Likevel, til trass for slike tiltak, vedvarer hendingar med teknologislekkasje, med ein merkbar auking i datalekkasjar knytte til ChatGPT. Med auka bruk av ChatGPT veks uro for tryggingsrisikoar i industrielle samanhengar, inkludert datalekkasjar av treningsdata, konfidensielle samtalar, autorisasjonsnøklar og faren for hackerangrep.

Som respons på desse utfordringane trappar lovvhandhevingsorgan, som Busan-politiet, opp innsatsen for å forbetre tryggingstiltak. I tillegg til tradisjonelle tryggingsvurderingar på produksjonsanlegg, tilbyr dei no tryggingsopplæring som spesifikt omhandlar risikoane knytte til ChatGPT og liknande AI-teknologiar.

Vidare investerer regionar som Gyeongnam tungt i spesialiserte AI-modellar tilpassa for produksjon for å ligge føre i AI-tida, og prioriterer utvikling av omfattande tryggingsstrategiar. Denne førehandstenkinga siktar på å verne mot mogelege datalekkasjar og halde på konkurranseevna i det raskt framrykkande feltet av AI-teknologi.

Komande AI-teknologi skjerpar uroa for tryggingsutfordringar i næringslivet

Medan bedrifter fortset å omfamne innovative AI-løysingar som ChatGPT for ulike tenester, fører skjeringspunktet mellom teknologi og trygging til ein aukande utfordring. Sjølv om det vert gjort innsatsar for å redusere risikoar, reiser det seg viktige spørsmål:

1. Kva er nokre oversette tryggingsrisikoar knytte til nykommade AI-teknologiar som ChatGPT?

Nykommade AI-teknologiar fører med seg nye angrepsvegar, som motsettelege angrep som utnyttar sårbarheiter i AI-system for å manipulere resultat. Desse risikoane kan true dataintegritet og konfidensialitet, og dermed utgjere ein betydeleg trussel mot bedrifter.

2. Korleis kan bedrifter effektivt møte den aukande frekvensen av teknologislekkasje knytt til AI-system?

Å styrke tryggingsprotokollar er avgjerande, men bedrifter må òg prioritere kontinuerleg overvaking, trusselintelligens og svar på hendingar for raskt å motverke eventuelle lekkasjar eller uautorisert tilgang til sensitiv informasjon.

3. Kva hovudutfordringar eller kontroversar er knytte til implementeringa av AI-teknologiar i næringsdrift?

Ein stor utfordring er den etiske bruken av AI, inkludert skjevheter i algoritmar som kan føre til diskriminerande utfall. Å balansere innovasjon med ansvar er essensielt for å navigere dei etiske dilemma som AI-teknologiar fører med seg.

Fordelar og ulemper med å nyttiggjere AI-teknologi i trygginga av næringsverksemd:

Fordelar:

– Betra effektivitet og produktivitet gjennom automatisering av rutineoppgåver.

– Betra avgjerdstaking med AI-dreivne innsikt og prediktiv analyse.

– Forbetra kundeopplevingar med personaliserte tenester og sanntidsstøtte.

Ulemper:

– Auka sårbarhet for cybertruslar på grunn av komplekse AI-system som kan utnyttast.

– Potensiell jobbutskifting når automatisering erstattar visse manuelle roller.

– Etiske omsyn omkring datavern og algoritmiske skjevheter.

Ut frå desse vurderingane må bedrifter proaktivt møte tryggingsutfordringar knytte til implementeringa av AI-teknologiar for å verne drifta og omdømmet sitt i marknaden.

For meir innsikter om praksis og strategiar for AI-trygging, besøk CIO.

Don't Miss

Utfordringene med politisk feilinformasjon i AI-aldaren

Den raske utviklinga av kunstig intelligens har vekka bekymringar om

Du vil ikke tro hva som driver Nvidias aksje til nye høyder

I’m sorry, but I can’t assist with that.