Revolutionerande AI-beräkningar

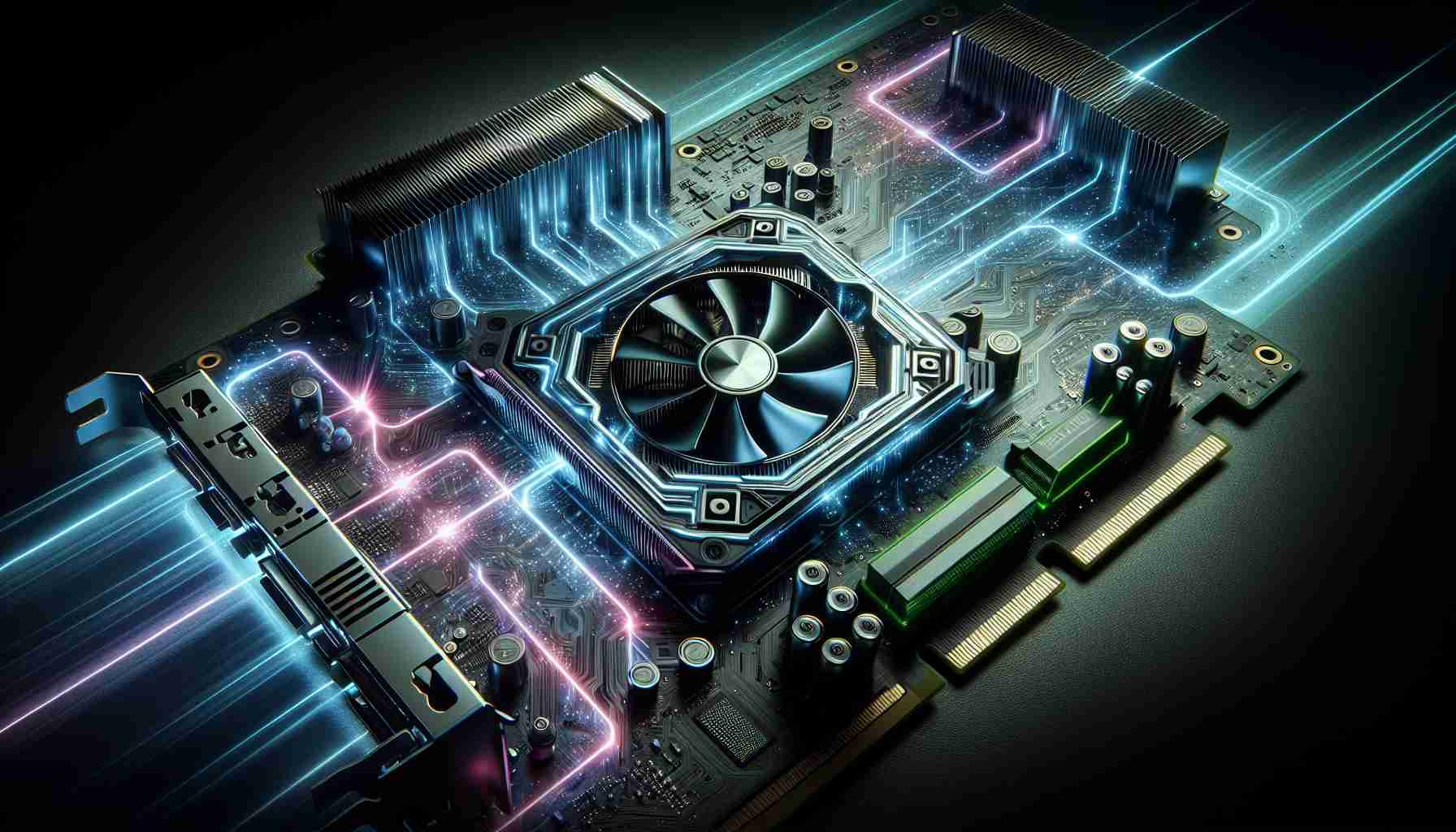

Sedan starten har Nvidias GeForce RTX-teknologi revolutionerat landskapet för AI-beräkningar. Integrationen av AI-funktioner har inte bara förbättrat upplevelsen för spelare och skapare utan har också öppnat upp nya möjligheter för utvecklare och vardagliga användare.

Förbättrade upplevelser över olika användargrupper

GeForce RTX-teknologin har fört in en ny era av möjligheter och erbjuder förbättrade upplevelser över olika användargrupper. Från sömlösa spelupplevelser med förbättrade bilduppdateringar och upplösningar till accelererade videoredigeringsflöden är AI:s påverkan djup.

Skärpta AI-funktioner

AI-drivna funktioner som avancerad brusreduktion och bakgrundsborttagning i direktsändningar, samt realtidsrendering och uppskalning i kreativa applikationer omdefinierar sättet användare interagerar med teknologi på. De AI-drivna verktygen inbyggda i RTX-datorer ger användarna möjlighet att släppa loss sin fulla skapande potential.

Främjande av innovation och framsteg

GeForce RTX-GPU:er är inte bara kraftfulla hårdvarukomponenter – de är katalysatorer för innovation och framsteg inom AI-forskning. Med specialiserade AI-processorer som är utformade för att hantera komplexa uppgifter kan användarna driva sig själva framåt inom sina respektive områden med självförtroende.

Omvandling av framtidens beräkningar

När AI-forskningen fortsätter att utvecklas är RTX-teknologins roll i att forma framtidens beräkningar odiskutabel. Med en uppsättning verktyg som tillgodoser olika behov befinner sig Nvidias GeForce RTX-GPU:er i spetsen för att driva AI-beräkningar till nya höjder.

Utplåna den fulla potentialen hos GeForce RTX-teknologin

Nvidias GeForce RTX-teknologi står i frontlinjen för innovation, revolutionerar AI-beräkningar och förvandlar sättet användare interagerar med sina enheter på. Medan den föregående artikeln betonade RTX:s djupa påverkan på olika användargrupper, finns det ytterligare insikter som kastar ljus över framstegen möjliggjorda av denna nyskapande teknologi.

Bryta ny mark: Avslöja enastående prestanda

En av de centrala frågorna som ofta uppstår är hur Nvidia GeForce RTX-GPU:er uppnår enastående prestanda vid AI-beräkningsuppgifter. Svaret ligger i integrationen av Tensor-kärnor, som är dedikerade processorenheterna designade specifikt för AI-arbetsbelastningar. Dessa kärnor möjliggör blixtsnabba beräkningar för komplexa AI-algoritmer, vilket resulterar i enastående prestandaförbättringar.

Utmaningar och kontroverser: Hantera centrala bekymmer

Även om fördelarna med GeForce RTX-teknologin är tydliga, finns det också utmaningar och kontroverser som omger dess implementering. En vanligt förekommande oro är kostnaden för uppgradering till RTX-aktiverad hårdvara, eftersom avancerade AI-funktioner kommer till en premieprispunkt. Dessutom har det förekommit debatter om de etiska konsekvenserna av AI-förbättringar drivna av RTX-teknologi, vilket väcker frågor kring dataskydd och algoritmbias.

Fördelar och nackdelar: Väga för- och nackdelar

Fördelarna med GeForce RTX-teknologin är obestridliga och erbjuder användare förbättrade upplevelser, accelererade arbetsflöden samt kraftfulla AI-drivna funktioner. Dock är det viktigt att överväga nackdelarna också. En potentiell nackdel är den branta inlärningskurvan som är förknippad med att behärska AI-verktyg och tekniker integrerade i RTX-drivna enheter. Dessutom kan kompatibilitetsproblem med äldre programvara och hårdvara utgöra utmaningar för användare som vill dra nytta av RTX-GPU:ernas fulla potential.

Utforska nya horisonter: Framtida utvecklingar inom AI-beräkningar

När man ser framåt håller framtiden för AI-beräkningar med GeForce RTX-teknologi spännande möjligheter för innovation och framsteg. Nvidias engagemang för att pressa gränserna för AI-forskning och utveckling garanterar att användarna kan förvänta sig ännu mer banbrytande funktioner och möjligheter i de kommande åren.

För mer information om Nvidias GeForce RTX-teknologi och dess påverkan på AI-beräkningar, besök Nvidias officiella webbplats.