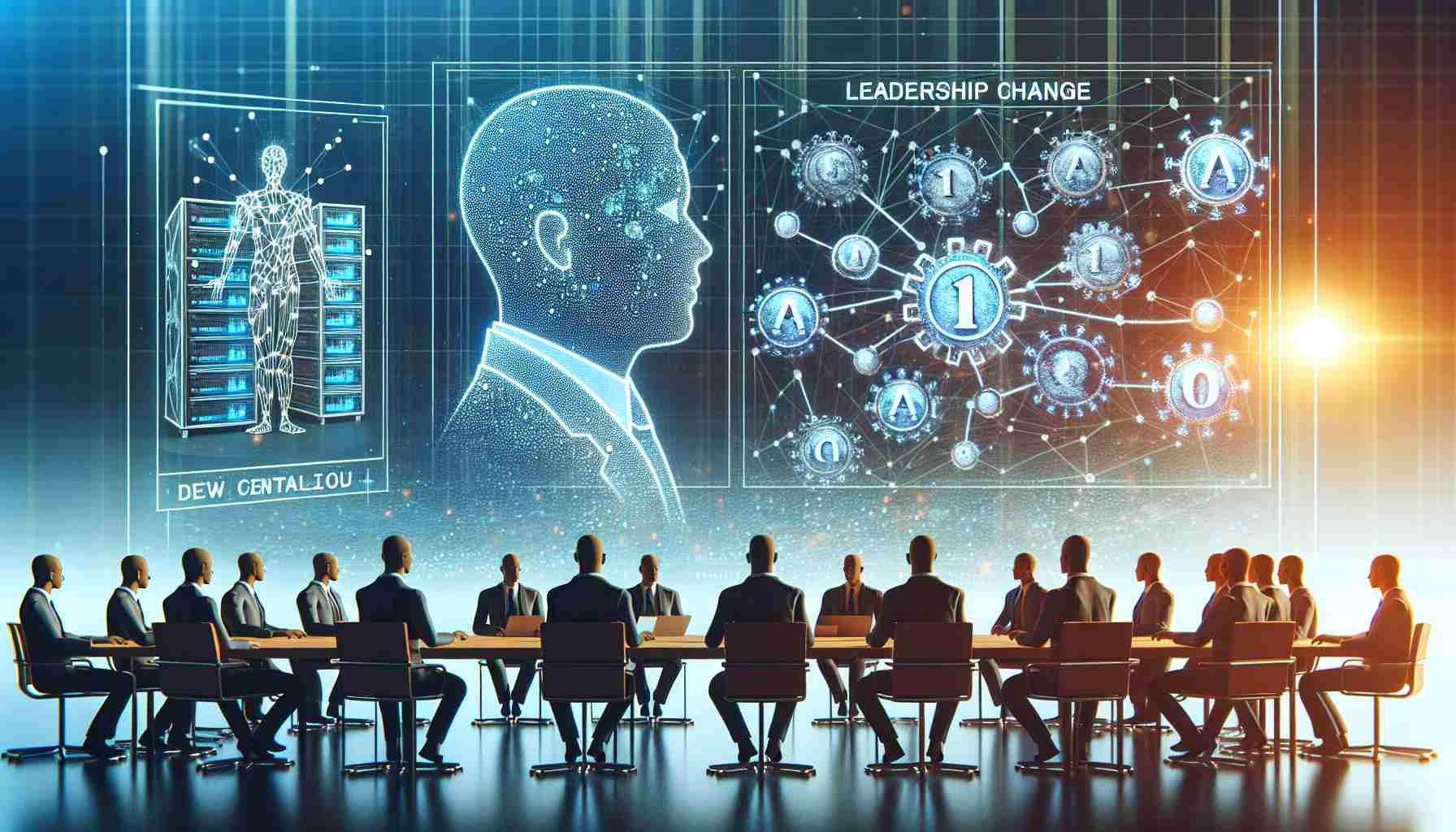

AI企業のスタビリティAI(Stability AI)は、創業者であるエマド・モスタック氏がCEOおよび取締役会からの辞任を表明した週末以降、リーダーシップに大きな変化を経験しています。モスタック氏の離任に伴い、スタビリティAIでは、最高執行責任者であるシャン・ウォン氏と最高技術責任者であるクリスチャン・ラフォート氏が暫定的な共同CEOとして任命されました。モスタック氏の後任を積極的に探しています。スタビリティAIによれば、モスタック氏は分散型AIの世界を探求するために企業を離れたと述べています。

モスタック氏は、自身のXプロフィールに投稿した声明で、次のように自らの決定について洞察を提供しました。「より中央集権的なAIを用いて中央集権的なAIを打ち負かすことはできない」と述べたモスタック氏は、AIがますます重要性を増す中で、透明性のある分散型ガバナンスが喫緊の課題であると信じています。彼は、「それが難しい問題であるとしても、それは解決可能だと堅く信じている」と述べ、この課題に取り組むことに楽観的です。

興味深いことに、モスタック氏の離任は、スタビリティAIにとって転換期となる時期と重なっています。会社は最近、画期的な技術である「ステーブルビデオ3D」を用いて、静止画を3Dオブジェクトおよび動画に変換するとされる画期的な技術を用いて、生成ビデオセクターを革新する計画を発表しました。モスタック氏は、スタビリティAIを指導し、数億のダウンロードを達成し、さまざまなモダリティにわたる先進的なモデルを開発することに誇りを感じています。モスタック氏は自らの役割を離れたにもかかわらず、スタビリティAIの使命に対する断固たる信念を持ち続け、現在企業を導く能力ある手に確信を抱いています。彼は、AIの開放性と分散性の重要性を強調しています。

しかしながら、スタビリティAIは2023年を通して障害に直面しました。ロンドンを本拠地とするスタートアップによるSiftedのレポートによると、昨年は10人以上のシニアエグゼクティブが離職し、内部での動揺の時期を迎えました。そのうちのひとりが、スタビリティAIのオーディオチームのリーダーであるエド・ニュートン・レックス氏の離職です。ニュートン・レックス氏は、「フェアユース」の理念の下で著作権作品を使用して生成AIモデルのトレーニングを行う会社の立場に異議を唱えたため、辞任したと述べました。

さらに、2023年の終わりには、スタビリティAIは投資家からの圧力に直面し、企業の買収に興味を持つ潜在的なバイヤーを探ることになりました。ブルームバーグの報告によれば、この報告はモスタック氏と投資家との間に葛藤があったことも指摘しています。

よくある質問:

Q: エマド・モスタック氏がスタビリティAIからの辞任に至った要因は何ですか?

A: エマド・モスタック氏はCEOおよび取締役会の職を離れ、分散型AIの概念を探求するためにスタビリティAIを離れました。

Q: モスタック氏の辞任後のスタビリティAIの暫定共同CEOは誰ですか?

A: シャン・ウォン氏(最高執行責任者)とクリスチャン・ラフォート氏(最高技術責任者)がスタビリティAIの暫定共同CEOに任命されました。

Q: モスタック氏はAIの開発においてどのような課題を認識していますか?

A: モスタック氏は、AIが重要性を増すにつれて、透明性と分散型ガバナンスの必要性があると考えています。彼は、AIが開かれ、分散化されたままであることの重要性を強調しています。

Q: エド・ニュートン・レックス氏がスタビリティAIを辞任した理由は何ですか?

A: スタビリティAIのオーディオチームのリーダーであるエド・ニュートン・レックス氏は、著作権作品を使用して生成AIモデルのトレーニングを行うことで、会社の立場に異を唱えたため辞任しました。

Q: 2023年にスタビリティAIがいくつかの課題に直面しましたか?

A: はい、スタビリティAIは、昨年に10人以上のシニアエグゼクティブが会社を離れるという内部的な課題に直面しました。また、投資家からの圧力にも直面し、企業の買収に興味を示していました。

スタビリティAIは急速に成長しているAI業界で活動しており、近年で大きな進展を見ています。健康、金融、小売りなどの様々な分野でAI技術やソリューションへの需要が高まっています。市場予測によれば、グローバルAI市場は2025年までに1900億ドルに達し、予測期間中のCAGRは36.6%に達するとされています。

ただし、この業界はいくつかの課題に直面しています。エマド・モスタック氏のスタビリティAIからの離任によって示されるように、透明性と分散型ガバナンスの必要性がその中心にあります。モスタック氏は、AIが中央集権化していく中で、AIシステムの公正さ、開かれた性質、責任を確保するために、分散型アプローチが必要であると考えています。

スタビリティAIが直面してきた問題のひとつに、2023年にSiftedが報じたように、複数のシニアエグゼクティブの離職があります。この内部的な動揺は、企業の運営および全体的な安定性に影響を与える可能性があります。スタビリティAIのオーディオチームのリーダーであるエド・ニュートン・レックス氏が辞任したのは、著作権作品を使用して生成AIモデルのトレーニングを行うことに関して会社の立場に異議を唱えたためです。

さらに、スタビリティAIは投資家からの圧力に直面し、企業の買収を探ることになりました。ブルームバーグの報告によれば、モスタック氏と投資家との葛藤が状況を悪化させました。これらの課題は、スタビリティAIに、戦略の再調整、内部のオペレーションの最適化、投資家の信頼の再構築を求めており、それが必要とされています。

これらの課題にもかかわらず、スタビリティAIは持続力と使命感を示しており、その使命を続ける決意を持っています。静止画を3Dオブジェクトや動画に変換する画期的な技術「ステーブルビデオ3D」の発表は、同社が革新に対する取り組みを示しています。スタビリティAIがAI業界の変化する景観に適応する能力と、モスタック氏の適任後任者を見つけることが同社の将来の成功にとって重要であるでしょう。

AI業界や市場予測についての詳細情報は、MarketsandMarketsやGrand View Researchなどをご覧いただければと思います。これらの情報源は、業界、市場動向、および予測について包括的な洞察を提供し、理解を深めるのに役立つ情報を提供しています。

[動画リンク](https://www.youtube.com/embed/J5OmmgAdNg8)… Read the rest