Revolutionerende AI-computing

Siden dens begyndelse har Nvidias GeForce RTX-teknologi revolutioneret landskabet inden for AI-computing. Integreringen af AI-funktioner har ikke kun forbedret oplevelsen for gamere og skabere, men har også åbnet op for nye muligheder for udviklere og almindelige brugere.

Forbedrede oplevelser på tværs af forskellige brugergrupper

GeForce RTX-teknologien har ført en ny æra af muligheder ind, og tilbyder forbedrede oplevelser på tværs af forskellige brugergrupper. Fra sømløse spiloplevelser med forbedrede billedhastigheder og opløsninger til accelererede video redigeringsprocesser er AI’s indvirkning dyb.

Topmoderne AI-funktioner

AI-drevne funktioner som avanceret støjfjernelse og baggrundsskift i live streaming, samt realtids rendering og opskalering i kreative applikationer, er ved at omdefinere måden, brugere interagerer med teknologien på. De AI-drevne værktøjer integreret i RTX-pc’er giver brugerne mulighed for at udfolde deres fulde kreative potentiale.

Styrke innovation og udvikling

GeForce RTX-GPU’er er ikke blot kraftige hardwarekomponenter – de er katalysatorer for innovation og udvikling inden for AI-forskning. Med specialiserede AI-processorer rettet mod håndtering af komplekse opgaver, kan brugere skubbe sig selv fremad inden for deres respektive områder med selvtillid.

Transformerer fremtiden for computing

Mens AI-forskningen fortsætter med at udvikle sig, er rollen som RTX-teknologien i at forme fremtiden for computing uomtvistelig. Med et værktøjssæt der imødekommer diverse behov, er Nvidias GeForce RTX-GPU’er i spidsen for at drive AI-computing til nye højder.

Frigivelse af det fulde potentiale af GeForce RTX-teknologien

Nvidias GeForce RTX-teknologi er førende inden for innovation, revolutionerer AI-computing og transformerer måden, brugerne interagerer med deres enheder på. Mens den foregående artikel fremhævede den dybe indvirkning af RTX på forskellige brugergrupper, er der yderligere indsigter, som kaster lys over de muligheder, der er muliggjort af denne topmoderne teknologi.

Skaber nye fremskridt: Afsløring af enestående ydeevne

Et af de centrale spørgsmål, der ofte opstår, er hvordan Nvidias GeForce RTX-GPU’er opnår en så enestående ydeevne i AI-computingopgaver. Svaret ligger i integrationen af Tensor-kerner, som er dedikerede processorenheder designet specifikt til AI-workloads. Disse kerner muliggør lynhurtige beregninger for komplekse AI-algoritmer, hvilket resulterer i enestående ydeevnegevinster.

Udfordringer og kontroverser: Adressering af nøglebekymringer

Mens fordelene ved GeForce RTX-teknologien er tydelige, er der også udfordringer og kontroverser, der omgiver dens vedtagelse. En almindelig bekymring er omkostningen ved at opgradere til RTX-aktiveret hardware, da de avancerede AI-evner kommer med en høj pris. Der har også været debatter om de etiske implikationer af AI-fremskridt drevet af RTX-teknologien, hvilket rejser spørgsmål om datasikkerhed og algoritmebiaser.

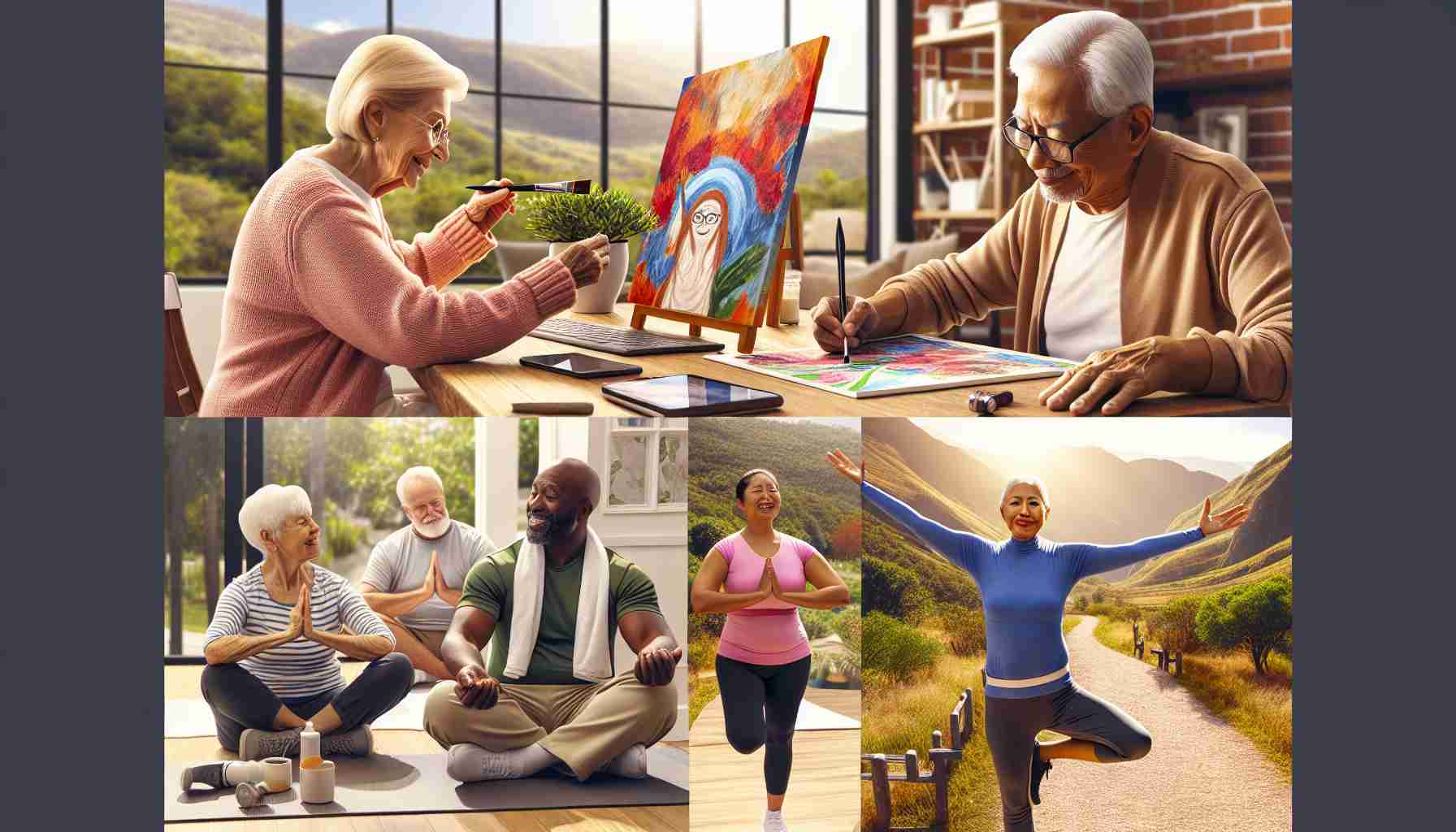

Fordele og ulemper: Vejning af fordele og ulemper

Fordele ved GeForce RTX-teknologien er uafviselige og tilbyder brugerne forbedrede oplevelser, accelererede arbejdsprocesser og kraftfulde AI-drevne funktioner. Det er dog vigtigt også at overveje ulemperne. En potentiel ulempe er den stejle indlæringskurve forbundet med mestrering af AI-værktøjer og -teknikker integreret i RTX-drevne enheder. Desuden kan kompatibilitetsproblemer med ældre software og hardware udgøre udfordringer for brugere, der ønsker at udnytte RTX-GPU’ernes fulde kapacitet.

Udforske nye horisonter: Fremtidige udviklinger inden for AI-computing

Når vi ser fremad, holder fremtiden for AI-computing med GeForce RTX-teknologi spændende muligheder for innovation og udvikling. Nvidias forpligtelse til at skubbe grænserne for AI-forskning og -udvikling sikrer, at brugerne kan forvente endnu mere banebrydende funktioner og kapaciteter i de kommende år.

For mere information om Nvidias GeForce RTX-teknologi og dens indvirkning på AI-computing, besøg den officielle Nvidia-hjemmeside.